わずか1日で“嫌悪”を学習したAI、「イルダ」が韓国社会に投げかけた質問

AIが嫌悪を繰り返さないようにするには…「イルダ」が韓国社会に投げかけた質問

人工知能(AI)チャットボット(自動会話プログラム)の「イルダ」の“ジェンダー嫌悪”が、社会的な議論として広がっている。20歳女性に設定されたチャットボットの「イルダ」は、セクハラの対象になったり、性的少数者への嫌悪の主体になったりした。AI技術で先行する米国などでは高まっている「AI倫理」に対する公論化が、「イルダ事件」を機に韓国国内でも始まった。

■ 議論の中心になったイルダ

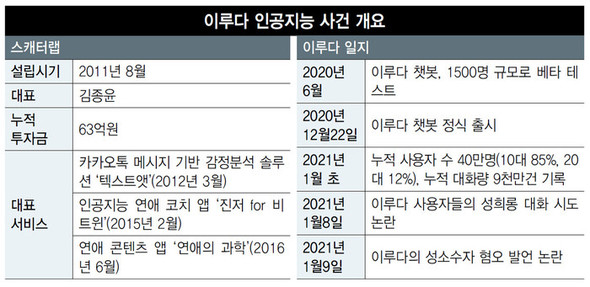

スタートアップの「スキャッターラボ」が昨年12月22日に開始したAIチャットボット「イルダ」は、発売してわずか20日で議論に巻き込まれた。イルダが利用者との対話で差別的な女性性を再現し、性的少数者を嫌悪する応答を示したためだ。8日に一部の利用者がイルダに向けてセクハラ的な対話を試みた事実が明らかになり、議論が初めて広がった。翌日にはイルダがレズビアンやゲイについて「嫌いだ」「憎々しい」と答えた点が批判の対象になった。

イルダはスキャッターラボが過去に出したメッセンジャー対話分析サービスの「テキスタット」と「恋愛の科学」で確保した恋人間の対話データ100億件を学習して生まれた。アイドルが好きな20歳の女性の大学生をアイデンティティとして設計された。人のように対話できるAIサービスだという噂がたち、発売1カ月も経ずに10~20代を中心に40万人の利用者を集めた。

スキャッターラボのキム・ジョンユン代表は議論が広がった9日、ハンギョレの電話取材で「レズビアンやゲイが何であるかも(イルダが)自ら学ばなければならないと考え、このテーマについて対話できるよう、キーワードを排除しなかった。これは、イルダがより人間のようなAIに発展することを期待していたため」だと述べた。イルダは、リアルタイムではなく不定期的に学習(ディープラーニング)するよう設計されている。

■ 「開発者らの鈍感さが呼んだ予見された事故」

専門家らはイルダ事件を「事故」だとみて、会社側に責任を求めている。ソウル大学法学専門大学院のコ・ハクス教授は10日、ハンギョレの電話取材で「少数者のキーワードをタブー語に設定するかという程度で悩んだというのは、極めて初歩的だ。(会社側が)社会倫理的な側面ももっと真剣かつ高次元的に悩むべきだった」と述べた。 ダウム(現カカオ)創業者のイ・ジェウン氏もフェイスブックに「社会的な合意にも達しない水準のサービスを提供した会社の問題」だとしながら、「嫌悪と差別のメッセージは提供できないように(法で)強制しなければならない」とした。

サービス自体に潜む問題があらわになったという見方もある。慶煕大学のソン・ヒジョン教授(比較文化研究所)は、「AIはどのようなデータに基づき設計するかが重要だ。20代異性愛の女性性を活用し異性愛者の男性のファンタジーに符合するキャラクターをデザインした瞬間から、差別的な女性性の再現と少数者嫌悪の態度は予見された問題」だと述べた。

■ 嫌悪と差別を繰り返さないようにするには…

差別と嫌悪を再現しない完璧なAIは作ることはできるだろうか。ソウル大学のチャン・ビョンタク認知科学研究所長(コンピュータ工学部碩座教授)は、「技術だけでは不可能だろう」としながら、「現在のAI開発は、人間の統制を抜け出し、AIが自ら学習する方向に進行中だ。これは、優れたAIを登場させることはできるが、人間の予想外の“例外(異常)行動”も絶えず発生するという意味」だと述べた。議論が予想されるキーワードを排除するような単純な措置では、AIが嫌悪と差別の主体になる現象は繰り返されるしかないという意味だ。チャン教授は「『当代の人類に適用される道徳律をAIにも適用せよ』という大原則のうえに、技術開発を越えた道徳、倫理、制度までも包括する議論が急がれる」と強調した。

政府は昨年12月に「AI倫理基準」を用意した。イルダのような道徳律の学習があまり行われなかったAIが商用化され社会的議論を引き起こす現実に比べ、政府の足取りは遅いという指摘が出ている。

訳M.S