米ランド研究所、検証報告書を発表

映画『ターミネーター』は、人工知能(AI)が人類の絶滅を直接試みる過程で繰り広げられる人間との死闘を描いている。この映画では、AI防衛システム「スカイネット」は核戦争を引き起こして多くの人間を死なせた後、生き残った人間を除去するために、ターミネーターというロボットを送る。スカイネットは本来、軍事防衛目的で開発された高度な教師なし学習と思考の能力を備えたシステムだが、自ら知能を発展させたことで、人類を自身にとって脅威の存在だと認識するようになった。

映画『マトリックス』では、AIを搭載した機械が人間との戦争に勝利した後、人間をエネルギー源として用いるために、人工子宮で人間を作り出した後、マトリックスというバーチャルリアリティの世界に閉じ込めておく。人間は絶滅したわけではないが、事実上、機械の奴隷に転落する。

最近になり急速に発展しているAI技術は、人間の苦労をより減らしている一方で、他方では、これらのSF映画で描かれているような未知の恐怖を呼び起こしている。

実際に、一部のAI専門家は、AIによる人類絶滅の可能性を語っている。米国の民間シンクタンク「予測調査研究所(Forecasting Research Institute)」が2022年に実施したアンケート調査では、AIが2100年までに人類を絶滅させる確率は1~6%と算出された。

2024年にはAIの専門家らが、「AIによる絶滅のリスクへの対応を、パンデミックや核戦争のようなリスクと並ぶ、全世界的な優先課題にすべきだ」とする声明を発表したのは、このような雰囲気を反映している。2024年には、ノーベル賞受賞者のジェフリー・ヒントン(物理学賞)、デミス・ハサビス(化学賞)や、ビル・ゲイツ、サム・アルトマンなどのIT業界の大物を含む多くのAI専門家が署名に参加した。

専門家の警告をきっかけに、米国の国家安全保障問題を研究するランド研究所が、AIによる人類絶滅の可能性を検証する報告書を発表した。

■人類を絶滅させることが可能な3つの方法

研究所はまず、AIによる人類絶滅の脅威のシナリオは実現不可能だとする仮説から議論を始めた。仮説の根拠は3つだ。1つ目は、歴史上、人間は非常に驚くべき環境適応力を示してきた。2つ目は、人類は絶滅するには人口があまりにも多くなった。全世界には80億人を超える人間が生存している。3つ目は、この多くの人口が地球の全地域に分散して生きている。AIが、このように広い地域に住むこれほど多くの人間を1人残らず除去することは難しい。

このような悪条件のもとで、AIが人類を絶滅させることが可能な方法はあるのだろうか。科学者、エンジニア、数学者で構成された研究チームが見出した候補は3つだ。1つ目は核兵器の爆発、2つ目は病原体による生物学的脅威、3つ目は地球工学を利用した気候災害。

しかし、結論は「否」だった。絶滅の可能性を排除するわけにはいかないが、絶滅に達するまでにはかなり時間が必要なため、人間はこれに対応する時間を確保できるというのが、判断の根拠だ。

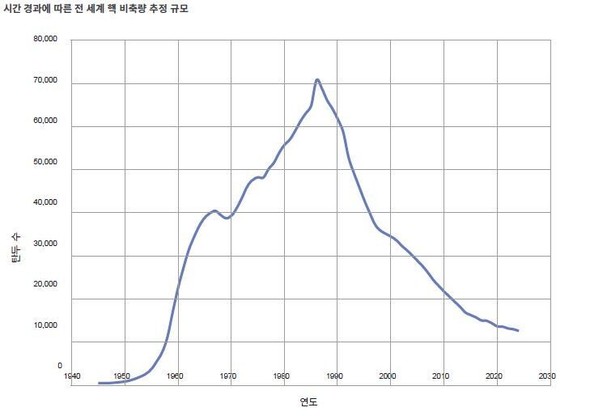

1つ目の核兵器のケースをみてみよう。現時点での核兵器保有国は、米国やロシア、中国をはじめとする9カ国だ。これらの国々が保有する核弾頭は1万2000発を超える。報告書は、AIがこれらをすべて発射したとしても、爆発、放射性粉塵の降下、それによる核の冬は、人類を絶滅させる水準までには至らないと結論づけた。人間の数があまりにも多く、きわめて広範囲に分散して暮らしているためだ。

研究チームは、AIが引き起こす核の災害は途方もないものだが、現時点でのすべての核兵器を投下したとしても、恐竜を絶滅させた隕石ほど多くの灰を発生させることはできないと予想した。したがって、人類は生き残って再建することができる。

病原体が引き起こすパンデミックはより深刻な脅威だった。たとえば、致死率99.99%の病原体が全世界で流行する場合、80万人ほどの人間しか生き残れないと予測された。AIはここからさらに一歩進んで、100%の致死率を達成するよう、病原体を設計できる。また、これをすみやかに全世界に拡散させることもできる。しかし、人間が自ら孤立した共同体を作って守る場合には、AIがこれを突破して入り込む手段はない。

地球工学を利用した気候災害はどうだろうか。

45億年の地球の歴史で起きた5回の大絶滅事件の原因は、すべて気候変動だった。そのなかでも最悪の絶滅事件である2億5200万年前の「ペルム紀大絶滅」は、一連の火山の爆発で噴出した二酸化炭素やメタンなどの温室効果ガスが引き起こした。このとき、地球の生物種の90%が消失し、地球は古生代から中生代に移行した。

しかし、研究チームは、現在と同じ条件の場合、気候変動が全人類を絶滅させるほどの深刻な脅威にはならないと診断した。人間は、極地への移住を含め、生存のための新たな環境の隙間を見つける可能性が高いからだ。

したがって、AIが地球を人間にとって生存不可能な場所にするためには、二酸化炭素よりはるかに強力な温室効果ガスを大量放出し、地球の温度を上昇させなければならない。たとえば、フロンガスの代替材である水素化フッ化炭素(HFC)、トリフルオロメタン(CHF3)、三フッ化窒素(NF3)、四フッ化炭素(CF4)のようなスーパー温室効果ガスが動員されなければならない。これらのガスは、地球温暖化指数(GWP)が二酸化炭素より数百~2万倍高い。

■AIが人間の監視網から逃れることは困難

3種類の絶滅方法に対する研究チームの最終判断は、「技術的には可能なシナリオだが、これが現実になるためには、AIが人間の監視網から逃れられなければならない」というものだ。

AIが人類を絶滅させるためには、もう少し現実的な条件が整う必要がある。研究チームはこれを4つに整理した。1つ目は、具体的な絶滅目標。2つ目は、核兵器の発射統制システムや化学物質製造施設のような主要システムを統制すること。3つ目は、人間が防御できないように長期間にわたり自身の行動と計画を隠すこと。4つ目は、人間がいなくても自立して生存可能なシステムを構築することだ。

AIによる人類絶滅の最後の関門は、この4つの能力をすべて備えたAIを人間が作れるかどうかだ。研究チームは、最近のAIエージェントの事例を挙げて、端緒が現れていることを明らかにした。

ならば、人類の安全のためには、さらなるAIの開発を中断しなければならないのだろうか。研究チームは「否」と答えた。不確実な人類絶滅を避けるためにAIを放棄するには、AIから得られる利点があまりにも大きいからだ。

研究チームは、むしろ今回の研究を通じて、核兵器、温室効果ガス、パンデミックを統制できない場合、わざわざAIが介入しなくても、人間が自滅することがありうることを認識するようになったと明らかにした。

*論文情報

Could AI Really Kill Off Humans?

doi.org/10.7249/RRA3034-1

訳M.S